SEO︰為什麼網頁刊登了 ,Google 搜尋卻找不到?

預計閱讀時間︰5 分鐘

你有沒有試過新網站推出後,在 Google 搜尋引擎卻找不到自己的網頁?或是更新網站後,搜尋結果依然顯示舊資料?遇到這些事情可以怎麼辦?導致以上情況的問題有千百種,但尋根究底,這些問題始終都是圍繞著 Google search engine (搜尋引擎) 所衍生的!

Google 搜尋引擎是怎樣運作的?

要知道爲什麽 search engine 中找不到公司已刊登的網頁,我們首先要瞭解 Google 搜尋引擎的運作方式。Google 搜尋引擎可簡單分爲三個階段,分別爲 Crawling(檢索),Indexing(建立索引)和 Ranking(排名)。

階段一:Crawling(檢索)

Google 會追蹤已知網頁的連結并連到不同網頁,以此發現其他新網頁。你可以把網絡世界想象為一個巨大的蜘蛛網,Google 無時無刻都依靠連結發掘新網頁,代表著蜘蛛網無時無刻都在不斷延伸。當 Google 發現你新發佈的網頁時,它會派爬蟲機器人像蜘蛛一樣在這巨大的網路上爬行,來檢索你網頁上的資料,包括文字、圖片、影片和程式碼等網頁資料。這就是在Crawling 階段會進行的事情。

階段二:Indexing(建立索引)

接下來 Google 繼續分析你網頁上的文字、圖片和影片等內容,把相關網頁資訊分類並且歸檔在 Google 的大型資料庫裏面。這過程就好像圖書館管理員收到新書後,將新書分類編目、然後收進圖書館的書架上。

階段三:Ranking(排名)

當人們在 Google 使用輸入關鍵字搜尋時,Google 就會從龐大的資料庫中,綜合各種考量及演算法,找到最相關的搜尋結果,推薦給使用者,為你的品牌帶來搜尋流量。

Crawling 方面問題

網頁剛剛刊登,Google 還沒有檢索到?

很多人一刊登新網頁,就急著去搜尋引擎檢索,卻始終找不到自己新刊登的網站。其實,Google 搜尋引擎就像每天 24 小時全年無休工作的圖書館管理員,每天不間斷地透過助手(爬蟲機器人)把新書(新網頁)歸類放到書架上(檢索結果)。但是效率再高,也需要時間去處理這些每分每秒都在不斷增加的新網頁。Google 在「 Search Console 說明」中有表明,提交索引建立要求後需要等待一、兩天至數週時間,時間長短會受到許多因素的影響。所以刊登後就急著去 Google 檢索,是有機會找不到的!

如果想確定搜尋引擎有否收錄到你的網頁,只需要在 search engine 上搜索 ”site:你的網址“ 就可以。以 FIMMICK Blog 為例,在 search engine 上輸入:“site:www.fimmick.com”,就可以看到引擎收錄的結果。

如果想加速 Google 檢索到你的網站,縮短等待時間,你可以到 Google Search Console 申請索引建立要求,以此幫助 Google 更快地發現並檢索你的網站內容。但只限於網址不多的情況,而且多次要求檢索同一網址並不會加快檢索速度。

網頁頁面不符合規定的標準

大家都知道,如果希望 Google 更快地檢索到公司網頁内容,自然要遵循它的游戲規則。如果違背這些規則,品牌網頁就會到 search engine 懲罰和降低排名。

例如,爲了避免佔用不必要的資料儲備庫空間,Google 通常不會把兩個差不多的網頁都收錄到它的 data base 中,就如一山不能藏二虎。如果你的網站頁面與其他網站內容高度相似或重複,缺乏原創、高質量的內容,Google 可能就不會幫你進行索引。同時,如果 Google 人員在審查内容時,看見不符合「垃圾內容政策」的内容,例如偽裝、惡意軟體和惡意行為、濫填關鍵字,就有機會降低你的排名,甚至直接把頁面直接刪除。

如果不想被降低 SEO 排名或受到 Google 的懲罰,請盡量不要把其他網頁内容直接放到自己品牌網頁中,或是在頁面上加入規範網址標籤,令 Google 得知文章作者是誰,從而進行索引。在建立網頁過程中也要仔細瞭解 Google 的「垃圾內容政策」,防止自己不小心踩到地雷。

Indexing 方面問題

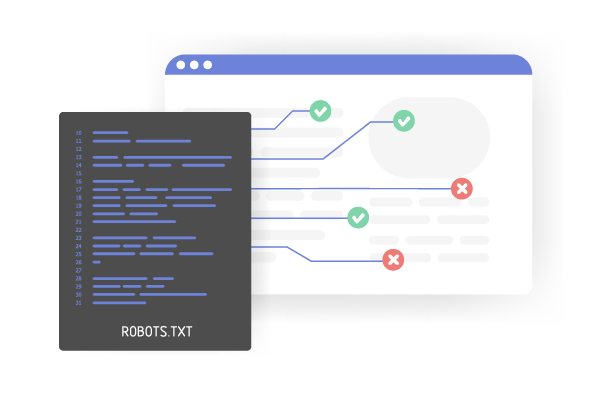

網頁機器人 (robot.txt) 設置出了問題,導致網頁内容無法被讀取

Robot.txt 主要告訴爬蟲機器人可以查詢自己網頁上哪些內容,同時拒絕機器人訪問你的顧客資料、後台等。但是如果你的 robot.txt 設定錯誤,小則網頁內容無法被正確檢索,重則把重要的顧客資料暴露在 Google 搜尋結果,只要任何人一搜尋,就能看到你公司顧客的名單、地址,聯絡方式等重要資料。

最常見在 Crawling 階段發生的問題是品牌在建立或更新網頁過程中,設定了 Robot.txt 去拒絕所有爬蟲機器人的訪問,但網頁完成後,卻忘記移除這項設定,最後導致 Google 爬蟲機器人完全無法讀取公司網頁内容。

雖然 robot.txt 只是一個不起眼的檔案,但在完成網頁後還是要謹慎地檢查一下網頁機器人的設定是否正確,避免因設定出錯而導致 Google 無法有效對網頁進行索引。

Ranking 方面問題

關鍵字競爭太大,把你的内容淹沒了

如果你確定 google 已經檢索到品牌網頁 ,但在搜尋特定關鍵字時,仍然找不到自己的網頁,那有可能你所選擇的關鍵字太熱門,加上公司網頁又太新,導致在排名上不占優勢。例如,你剛剛建立了一個網上運動服裝購物平臺,但是當你搜尋「運動服飾」時,出現的全部都是知名運動服飾品牌。原因是這些網頁已經建立良好品牌聲譽,Google 自然會優先顯示這些網頁。

因此,如果你的網頁是剛剛起步,不建議選擇一些熱門關鍵字,與大品牌競爭。可以參考使用長尾關鍵字策略,選擇一些更精準、尋量較低的關鍵字群,不只精準命中顧客群,也容易讓網頁搜尋置頂,突圍而出。

FIMMICK 為你輕鬆製作大量專業、獨到的 SEO 內容!

想提升網站的 SEO,但內容營銷耗時耗力,你是否渴望有一個省時省力的解決方案?FIMMICK 的 AIGC 內容創建服務就是你的得力助手!我們能為你生成一篇篇教育性、資訊豐富的博客和文章,助你提升 SEO 排名,獲取更多有機流量,輕鬆吸引目標客戶。即便是專業的 B2B 文章,也能輕鬆應對。立即與我們聯繫,探索更多可能!

總結

當然,除了這些潛在原因,還有很多不同原因影響到搜尋結果。例如網頁植入了惡意程式被 Google 屏蔽、網頁被列入黑名單等…… 我們建議大家可以時常留意 Google search engine 的最新消息,了解更多它們的運作方式,從而避免自己品牌網頁無法被搜尋。

SEO 系列文章

相關服務

相關文章

Ecommerce: 6 Critical Things Ecommerce Startups Often Miss

Launching an online business is exciting, but many startups stumble over critical early steps. Let’s explore the 6 items startups often miss.

SEO: 6 Steps to Boost Domain Authority – A How-To Guide

Domain authority is what gets you higher rankings, more organic traffic, and ultimately, more customers. Here’s our 6 steps how-to guide.

Ecommerce: Ecommerce SEO Top Strategies, Tips and Tools

Struggling to drive traffic to your online store and convert browsers into buyers? Discover the best practices and tips for ecommerce SEO.